Gemeinsam für eine aufgeklärte Jugend

Gemsensprung GmbH unterstützt Suchtprävention am Rupert-Neß-Gymnasium

Heute möchte ich von einer besonderen Initiative berichten, die uns als Gemsensprung GmbH am Herzen liegt und die wir mit voller Überzeugung unterstützen: Unsere Spende an den Verein Sucht- und Jugendhilfe e.V., welche die Bestellung von Ratgebern zur Aufklärung und Vorsorge für das Rupert-Neß-Gymnasium in Wangen beinhaltet.

Dieses Engagement ist für uns nicht nur eine Verpflichtung, sondern eine Herzensangelegenheit. Mein eigenes Kind besucht das Rupert-Neß-Gymnasium, und so ist es ist mir als Vater und Geschäftsführer umso wichtiger, einen Beitrag zu leisten, um die Jugendlichen unserer Gemeinschaft aufzuklären und zu unterstützen.

Der Verein Sucht- und Jugendhilfe e.V. engagiert sich leidenschaftlich in einer Zeit, in der das Thema Sucht leider oft im Schatten steht. Die Vielfalt der heutigen Suchtformen, angefangen von Abhängigkeiten von bestimmten Substanzen wie Drogen, Alkohol oder Medikamenten bis hin zu stoffungebundenen Süchten, zum Beispiel Magersucht, erfordert unsere Aufmerksamkeit. Sucht betrifft Menschen aus allen Gesellschaftsschichten, und es ist an der Zeit, das Tabu zu brechen.

Jugendliche stehen vor vielfältigen Herausforderungen und sind häufig einem enormen Druck ausgesetzt. Die Gemsensprung GmbH möchte nicht nur finanziell unterstützen, sondern auch dazu beitragen, Jugendliche umfassend über die Gefahren von Sucht aufzuklären. Die erste Prävention ist Wissen, und daher sind die Ratgeber für das Rupert-Neß-Gymnasium ein Schritt, um dieses Bewusstsein zu schärfen.

Es ist wichtig zu verstehen, dass Sucht eine Krankheit ist und nicht das Ergebnis menschlichen Versagens. Unsere Gesellschaft sollte sich von überholten Vorstellungen lösen und Verständnis für die Situation der Betroffenen aufbringen. Dieser Weg erfordert Aufklärung, Prävention und vor allem die Bereitschaft jedes Einzelnen, sich mit der Suchtproblematik auseinanderzusetzen.

Die Gemsensprung GmbH ist stolz darauf, einen nachhaltigen Beitrag zu leisten, und ich persönlich freue mich, dass wir nicht nur als Unternehmen, sondern auch als Eltern aktiv werden können. Es ist eine Gelegenheit, unsere Verantwortung gegenüber der Gemeinschaft und der nächsten Generation wahrzunehmen.

Für weitere Informationen über die wertvolle Arbeit des Vereins Sucht- und Jugendhilfe e.V. besucht bitte deren Webseite: https://www.suchthilfeverein.org/

Die globale Datenmenge explodiert: Blüht uns der Dateninfarkt?

Als ich mich das letzte Mal 2017 mit dem weltweit steil ansteigenden Speicherbedarf beschäftigte, wurden für das Jahr 2020 ehrfurchtsgebietende 44 Zetabyte prognostiziert. Heute, fünf Jahre später hat die Realität diese Fabelzahl dramatisch in den Schatten gestellt. Nicht nur wurde dieses Speichervolumen bereits ein Jahr vorher erreicht, sondern fiel im Referenzjahr 2020 auch noch um ein Drittel höher aus als es sich der optimistischste Speicherhersteller hätte träumen lassen. Ganze 64 Zettabytes an Daten wurden 2020 erzeugt, verarbeitet, verteilt und konsumiert.

Die Pandemie fungiert als Brandbeschleuniger

Corona hat uns ins Home-Office verbannt und damit dafür gesorgt, dass in einer noch nie dagewesenen Weise gestreamt, gechattet und video-conferenced wurde.

Experten schätzen, dass sich das Datenvolumen bis 2025 auf über 180 Zettabytes verdreifachen wird. Nur um diese Entwicklung greifbarer zu machen: 2010 wurden im digitalen Universum insgesamt 1,2 Zettabytes an Daten produziert. Bis 2025 soll nun das jährliche Datenvolumen auf über 180 Zettabytes [1] anwachsen. Noch plastischer ausgedrückt: Würde man diese Datenmenge auf iPads (iPad Air mit 128 GB Speicherkapazität und 0,8 cm Bauhöhe) speichern und stapeln, würde der Stapel 2025 knapp dreißigmal der Entfernung Erde-Mond entsprechen. Damit hat sich das gesamte Datenvolumen des digitalen Universums innerhalb einer Generation um das 150-fache vergrößert. Eine unvorstellbare Entwicklung. Es steht zu befürchten, dass der weltweite Datenhunger diese Entwicklung noch zusehends beschleunigen wird.

Für Menschen sind diese Datenmengen bereits heute nicht mehr beherrschbar

Hinter diesen Speichermengen steht eine schwindelerregende Anzahl von Dokumenten, E-Mails, Informationen und Daten, die im Administrationsalltag von Unternehmen und ihren Mitarbeitern verarbeitet werden müssen.

Bereits heute verbringen Mitarbeiter bis zu einem Tag pro Woche allein mit dem Suchen von Informationen (Daten, Dokumente). Dieses Bild hat sich seit 2010 kaum verändert. Technologische Verbesserungen im Büroalltag wurden immer wieder durch das rasante Datenwachstum egalisiert.

In einer kürzlich veröffentlichten US-Studie bestätigt jeder zweite Büromitarbeiter bereits jetzt mehr Zeit für das Suchen von Dokumenten und Dateien aufwenden zu müssen als für die Bearbeitung von E-Mails und Nachrichten.

Der damit einhergehende Produktivitätsverlust und die weiterhin rasant ansteigende Daten- und Dokumenten-indizierte Verarbeitungskomplexität rücken Verwaltungsprozesse immer häufiger in den Mittelpunkt von Optimierungsprojekten.

Es blüht der Dateninfarkt

Unglaublich, aber wahr. Viele Unternehmen verarbeiten einen Großteil ihrer Daten immer noch manuell. Eine Studie des McKinsey Institutes hält 50% der Prozessverarbeitungen in Unternehmen für automatisierbar, eine Kofax-Studie geht hier sogar noch weiter: Drei Viertel der Befragten halten 60% der Daten-Verarbeitungsschritte für automatisierbar, ein Fünftel geht sogar von 80% aus.

Viele Bestandsprozesse sehen sich einer stetig wachsenden Bearbeitungskomplexität ausgesetzt: Kleinere Losgrößen, eine Zunahme von Einzelkomponenten in Produkten, eine steigende Anzahl von internen und externen Datenquellen und Kommunikationskanälen, um nur einige der Komplexitätstreiber zu nennen.

Darunter leiden Bearbeitungs- und Durchlaufzeiten. Der echte Wertschöpfungsanteil an der aufgewendeten Arbeitszeit sinkt zunehmend, die Fehlerrate in der Bearbeitung steigt. Für Firmen eine Worst-Case Entwicklung.

Unternehmen sind unvorbereitet

Unternehmen sind sich dieser Probleme sehr wohl bewusst. Umso erstaunlicher, dass viele Organisationen zögern ihre Prozesse zu automatisieren oder dort den großen Hammer verwenden wo eine Pinzette reichen würde. Großprojekte wie SAP-Hanna, SalesForce oder e-Commerce Einführungen lösen die aktuellen Prozessprobleme nicht sondern verschärfen sie zunächst nur. Die Einbindung der Bestandprozesse, in solche langjährigen Großprojekte, vor dem Kontext der Unternehmensrealität führt oftmals zu unzähligen Workarounds und Zusatzaufgaben die weitere manuellen Verarbeitungsschritte nach sich ziehen.

Fazit

Bevor Unternehmen zum Hammer greifen, sollten im Vorfeld Prozesse analysiert und optimiert werden. In vielen Fällen lassen sich mit dem Einsatz einfacher Innovationen große Erfolge erzielen. Beispielsweise lassen sich mittels Robotic Process Automation (RPA) bereits viele manuelle Arbeitsschritte automatisieren. Arbeitsaufwände, Durchlaufzeiten und Fehlerquoten können dadurch teilweise dramatisch reduziert werden. In nächster Zeit wird auch IPA (Intelligent Process Automation), d.h. der Einsatz KI-gestützter Prozessautomatisierung eine immer größere Rolle spielen. IPA-Architekturen kommen u.a. immer häufiger in der Verarbeitung, Verwaltung und Strukturierung von Informationen und Daten zur Anwendung.

Erst wenn ein großer Teil der Prozesse automatisiert abläuft, entsprechend schnelle Durchlaufzeiten und geringe Fehlerquoten vorweisen kann, sollten Unternehmen darüber nachdenken den großen Hammer zu schwingen.

[1] Zum besseren Verständnis: 189 Zettabytes entsprechen 180 Billionen Gigabytes oder ausgeschrieben die Zahl 180 mit 21 Nullen, also 180.000.000.000.000.000.000.000 Bytes.

[2] https://der-prozessmanager.de/aktuell/publikationen/abbyy-studie-mitarbeiter-verlieren-bis-zu-einem-tag-pro-woche-zeit-mit-der-suche-nach-dokumenten, abgerufen am 20.02.2022 um 17:50 Uhr

[3] https://www.techrepublic.com/article/more-than-50-of-office-pros-spend-more-time-searching-for-files-than-on-work/, abgerufen am 20.02.2022 um 17:45 Uhr

[4] https://www.kofax.de/learn/blog/manual-processes-fully-optimized-you-are-primed-for-automation, abgerufen am 22.02.2022 um 17:59 Uhr

Rupert hat dich neugierig gemacht? Lies hier einen weiteren Blog-Artikel von ihm: Mitarbeiter verschwenden bis zu einem Tag pro Woche mit Informationssuche - Gemsensprung GmbH

Mitarbeiter verschwenden bis zu einem Tag pro Woche mit Informationssuche

Laut einer kürzlich veröffentlichten Studie wenden Mitarbeiter bis zu 8 Stunden pro Woche für das Suchen von Informationen auf.

Das Problem ist bei weitem nicht neu. Schon seit längerem zeigen Untersuchungen immer dasselbe Bild. Das Aufspüren von Informationen nimmt teilweise schon detektivische Ausmaße an. Ein nicht unerheblicher Teil der Wertschöpfung wird tagtäglich für das Durchforsten von Daten und Dokumenten aufgewendet. Die Informationssuche stellt somit mit Abstand den größten Produktivitätsfresser im Büroalltag dar. Tendenz steigend.

Technologische Innovationen, die Datenakquise-Prozesse zu beschleunigen, wurden in der Vergangenheit immer wieder durch das rasante Datenwachstum egalisiert.

Im Hamsterrad täglichen Suchens und nicht immer Findens von Information

Jeder zweite Büromitarbeiter verbringt bereits jetzt mehr Zeit mit dem Suchen von Informationen als für die Bearbeitung von E-Mails und Nachrichten. Im Zusammenspiel hierarchischer Abstimmungsprozesse, verlangsamt diese Entwicklung teilweise ohnehin bereits lange Entscheidungswege zusehends.

Im Raum steht mehr und mehr die Frage wieweit Unternehmen überhaupt noch in der Lage sind, Daten termingerecht, vollständig und korrekt aus dem eigenen Datenbestand abzurufen und zu interpretieren. Diese in vielen Unternehmen noch stark manuell gestützten Prozesse bilden oft einen ungeliebten Engpass.

Und nicht nur das. In einem konkreten Fall konnte ich sogar miterleben, dass ein Unternehmen einen Rechtsstreit aufgrund nicht mehr auffindbarer Dokumente verlor. Der Schaden für die Organisation betrug dabei mehrere Millionen Euro.

KI gestützte Datenmarktplätze als Drehscheibe der Datenbeschaffung

Abhilfe schaffen kann hier die Einführung eines einheitlichen Daten-Gesamtsystems, ein sogenannter „Datenmarktplatz“ der unabhängig von Ort und Quelle agiert.

Im Wesentlichen bieten diese unternehmenseigenen „Datenmarktplätze“ der Organisation alles aus einer Hand an, gehen dabei aber weit über die Rolle eines klassischen Data Warehouse hinaus. Ist ein Data Warehouse oft ein Sammelplatz stark aggregierter und kopierter Datenbestände vereint ein Datenmarktplatz den unverfälschten Zugang zu allen Unternehmensinformationen. Inhaltlich ist ein Datenmarktplatz mit einer Sammlung von „Wegweisern“ zu vergleichen welche Ort, Umfang und Quelle der Originalinformation (bzw. Dokumente) enthält. Diese „Bibliothek“ wird nun von Software Robotern betrieben, die ähnlich einer Maschine in einem physikalischen Warenlager Informationen verarbeitet, verstaut und abruft. Hier spielen künstliche Intelligenz und andere kognitive Technologien bereits eine große Rolle, um einen schnellen Zugang zum Datenbestand zu gewährleisten.

Diese kognitiven Agenten (Daten-Bots) sind für die Verwaltung aller Datenprozesse und die Steuerung aller administrativen Aufgaben verantwortlich. So unterstützen sie die tagtäglichen Aufgaben einer Organisation und ermöglichen in einer agilen Geschäftswelt rasche Ergebnisse, die nicht mehr vom Wissen und der Entscheidungsfähigkeit einzelner Mitarbeiter abhängen. Daten-Bots können Geschäftsanforderungen in den richtigen Kontext setzen, eigenständige Auswertungen, Interpretationen und Erkenntnisse ermöglichen und relevante Unternehmenskennzahlen überwachen.

Gleichzeitig sind sie in der Lage, Daten zu lokalisieren und mit entsprechenden Metadaten zu einem umfassenden Datensatz zu verknüpfen.

Fazit

Anwender erfahren durch diese Art der ganzheitlichen Integration elementare Hilfestellung, die für ihre Marktsituation und Geschäftsabläufe am besten geeigneten Daten auszuwählen und so manuelle Suchen überflüssig zu machen.

Pistentouren – Die sanfte Revolution

Und wieder ein Corona-Winter. Der Zweite. Wer hätte noch vor einem Jahr geglaubt, dass wir anfangen werden, die Corona-Jahreszeiten zu nummerieren.

Einreisebeschränkungen, Quarantäne bei Einreise und/oder Wiedereinreise, Lockdowns, geschlossene Skigebiete, 2G, 3G plus und viele weitere Corona-Maßnahmen der Politik treffen den Wintertourismus hart.

Kein Wunder also, dass Wintersportler seit Beginn der Pandemie immer wieder nach Auswegen suchen. Einen Ausweg bietet das Skitouren-Gehen. Wurde der erste Corona-Winter 2020/21 bereits von einem starken Skitouren-Boom geprägt, so vollzieht sich in seinem Schatten ein weiterer Wandel. Das Aufkommen des Pistentourings.

Der Einstieg ins Skitouring

Die Vorteile für Wintersportler liegen auf der Hand[1]: Pistentouren stellen einen niedrigschwelligen Einstieg dar, frei von den damit verbundenen Hürden wie alpiner Erfahrung, Tiefschneetauglichkeit und Lawinenkunde.

Pistentouren sind für viele eingefleischte Tourengeher schon lange zum Fitnessstudio-Ersatz geworden: eine schnelle, effektive Trainingseinheit für die großen Tourenziele im freien Gelände. Dazu gesellen sich seit einigen Jahren immer mehr Sportler, die im Pistentourengehen eine ganz eigene Disziplin für sich entdeckt haben.

Touren im freien, alpinen Gelände? Müssen nicht sein, die neue Touren-Community ist vollauf zufrieden mit ihrem Sport am Pistenrand. Corona und die daraus resultierende Lockdown-Situation mit den geschlossenen Liftanlagen wirken hier wie ein Katalysator.

Pistentourer, die Rebellen der Piste

Für Wintersportler ist das schon fast ein gewohntes Bild: Hier Tourengeher, die sich auf und neben der Piste langsam den Hang hochquälen. Dort Skifahrer die Tourengehern oft erst auch in letzter Sekunde ausweichen. Zwei Welten prallen aufeinander. Im Sog des Skitourings entwickelt sich die Zahl der Pistentouren-Geher explosionsartig. Dieser Trend stellt viele Skigebietsbetreiber vor große Herausforderungen: Wie soll mit der steigenden Zahl der Pistentourer umgegangen werden? Will man die Tourengeher komplett von den Pisten verbannen oder stellen sie eine willkommene Ergänzung für Tourismus und Gastronomie dar?

Verantwortliche wie Matthias Stauch[2], Präsident des Verbands Deutscher Seilbahnen und Schlepplifte e.V. und Vorstand Bayerische Zugspitzbahn Bergbahn AG Garmisch-Partenkirchen, sehen darin eine dauerhafte Veränderung des Wintersportbetriebes, auf die Tourismusbranche und Liftbetreiber eine Antwort finden müssen: „Die Situation an sich ist nicht neu. Der Trend zum Tourengehen bzw. Pistentourengehen entwickelt sich seit Jahren, und auch Aktivitäten wie Schneeschuhwandern und Rodeln gewinnen an Bedeutung.“

Auf zahlreiche Fragen gibt es derzeit noch zu wenige befriedigende Antworten auf die drängendsten Fragen: Wie können Skifahrer und Tourengeher sicher und friedlich dieselben Pisten nutzen? In welchem Maße sind Pistentourer auch bereit die Pistenpflege mitzutragen? Welche Angebote sind darüber hinaus möglicherweise für Tourengeher noch von Interesse?

In einigen Skigebieten finden sich mittlerweile schon eigene gewalzte Aufstiegsspuren für Tourengeher, die räumlich von der Piste getrennt sind. Andere Betreiber verbieten nach wie vor Pistentouring auf ihren Anlagen.

Solange es auf diese Fragen keine endgültigen, zufriedenstellenden Antworten gibt, werden Tourengeher die sanften Rebellen auf den Alpinpisten bleiben.

Neue Chancen für den Wintertourismus

Schafft es die Branche aus den Erfahrungen der beiden Corona-Winter zu lernen, lassen sich mit neuen Geschäftsmodellen neue Gästepotentiale erschließen. Die Möglichkeiten sind mannigfaltig: Von der Inkludierung des Tourengehens im Saisonpass bis hin zu ausgewiesenen und gekennzeichneten Aufstiegsrouten.

Experten fordern daher schon seit einiger Zeit die Emanzipation von einseitigen Alpinski-Konzepten.

Hybride Modelle welche die sanfteren Seiten des Wintersport-Tourismus wie Tourengehen, Langlaufen oder Schneeschuh-Wandern einschließen, werden nicht nur neue Gästepotentiale erschließen, sondern auch die Attraktivität der Wintersportgebiete deutlich steigern und das Gesicht des Wintersports nachhaltig verändern.

[1], [2] https://www.ispo.com/maerkte/corona-winter-2021-die-sanfte-rebellion-des-pistentourings, abgerufen am 06.01.2022 um 17:59 Uhr

Prozessentropie - Sisyphos lässt grüßen

Schon die alten Griechen waren mit dem Konzept mühseligen Arbeitens ohne absehbares Ende bestens vertraut. Als Erklärung dienten ihnen die Götter. Derlei Mühsal konnte wohl nur denjenigen treffen, der so vermessen war sich mit den Göttern selbst anzulegen.

Als Allegorie für das göttliche Strafgericht muss seit nunmehr dreitausend Jahren der unglückselige thessalische Königssohn Sisyphos herhalten. Homer beschreibt sein Leiden in seiner Odyssee (11. Gesang, 593 bis 600) auch entsprechend bildhaft mitfühlend:

„Und weiter sah ich den Sisyphos in gewaltigen Schmerzen: wie er mit beiden Armen einen Felsblock, einen ungeheuren, fortschaffen wollte. Ja, und mit Händen und Füßen stemmend, stieß er den Block hinauf auf einen Hügel. Doch wenn er ihn über die Kuppe werfen wollte, so drehte ihn das Übergewicht zurück: von neuem rollte dann der Block, der schamlose, ins Feld hinunter. Er aber stieß ihn immer wieder zurück, sich anspannend, und es rann der Schweiß ihm von den Gliedern, und der Staub erhob sich über sein Haupt hinaus.“

Klar, sich mit Thanatos, dem Totengott selbst anzulegen, wie es Sisyphos tat, klingt auch dreitausend Jahre später nicht nach einer smarten Strategie.

Prozesse werden durch ihre Entropie definiert

Sisyphosarbeit als Strafe: seit jeher die Rezeption in unserem Kulturkreis. Auch als Prozessmanager fühlt man sich bisweilen an Sisyphos erinnert. Warum eigentlich?

Prozesse entwickeln sich immer weiter. Ab dem Moment ihrer Inbetriebnahme verändern sie sich, auch ganz ohne bewusstes Zutun der Organisation. Mitarbeiter kommen und gehen, neue Software wird installiert, alte Gebäude werden verlassen und neue bezogen – all das und noch vieles mehr bleibt nicht ohne Auswirkung auf die Prozesse. Letztlich folgen auch Prozesse lediglich einem physikalischen Grundprinzip, dem Entropiegesetz: Die „Unordnung“ (Entropie) in einem System nimmt mit der Zeit unaufhaltsam zu. Mit anderen Worten: Ohne kontinuierliche Prozesspflege neigen Prozesse stets dazu, sich zu verschlechtern. Für den Alltagsverstand ist das eigentlich kaum überraschend. Denken Sie nur einmal an Ihr Zuhause: Wenn sie wochenlang nicht aufräumen und saubermachen, wird es Ihnen wenig Freude machen nach Hause zu kommen.

Ähnlich ergeht es Prozessen, die ohne Pflege ablaufen. Sie können ihr Leistungsniveau nicht halten. Die Fehlerquote steigt, der Durchsatz sinkt, die Durchlaufzeit nimmt zu, um nur einige der Symptome mangelnder Fürsorge zu nennen.

Kehren wir noch einmal zu Ihrer unaufgeräumten Wohnung zurück. Wenn Sie die Unordnung beseitigen wollen, dann müssen Sie Energie aufwenden, um wieder Ordnung zu schaffen. Ganz praktisch gesprochen bedeutet das: Geschirr spülen, Wäsche waschen, bügeln, den Boden saugen und wischen. All die schönen Dinge, die einen Haushalt führen ebenso ausmachen.

Prozessmanagement ist in erster Linie genau das: Prozesspflege und Erneuerung. Ein stetiges bergaufrollen von Steinen (hier hatte es Sisyphos definitiv leichter, er musste ja nur einen hochrollen). Wie Sisyphos müssen Prozessmanager immer wieder aufs Neue Energie aufwenden, um den Prozess auf sein ursprüngliches Leistungsniveau zurückzuführen.

Sisyphos steht aber nicht nur als allgemeinsprachliche Metapher für sinnlose Mühen, sondern beschreibt auch den Versuch mit eigener Hände Arbeit etwas zu erschaffen, eine Verbesserung herbeizuführen.

Sehen wir dabei einmal großzügig darüber hinweg, ob er das aus eigenem Antrieb oder gezwungenermaßen macht. Ohne seinen Einsatz würde der Stein jedenfalls für immer im Tal liegenbleiben und nie den Berggipfel erreichen. Sicher, man kann auch trefflich darüber streiten wie sinnvoll ein Vorhaben sein kann einen runden Felsblock immer und immer wieder einen steilen Berghang hinaufzurollen. Andererseits hätten unsere Vorfahren Steine schleppen zur sinnlosen Aufgabe erklärt, hätte sich wohl niemand die Mühe gemacht Pyramiden, Schlösser oder Kathedralen zu erbauen.

Und nun? Es geht auch anders!

Bevor wir uns dieser tristen Deutung, Prozessmanagement ähnle Sisyphosarbeit, anschließen, möchte ich noch gerne eine alternative Denkfigur ins Feld schicken. Schließlich, wer möchte schon gerne einen Job wie Sisyphos haben?

Auch der französische Philosoph und Schriftsteller Alber Camus hat sich dem zeitgenössischen Sisyphosbild genähert, sich aber für eine radikale Neuinterpretation des Mythos entschieden:

„Der Kampf gegen Gipfel vermag ein Menschenherz auszufüllen. Wir müssen uns Sisyphos als glücklichen Menschen vorstellen.“

Damit etabliert Camus eine existentialistische Sichtweise auf den Mythos Sisyphos. Sisyphos ist nicht mehr der „Bestrafte“, der tagtäglich einen Felsblock den Berg hochrollt, sondern ein in hohem Maße mit sich selbst zufriedener Mensch.

Wie anders die Interpretation desselben Bilds auch in einem anderen als dem abendländischen Kontext ausfallen kann, zeigt die altindische Legende von Naranath Bhranthan: So wie Sisyphos wälzte auch er immer wieder, allerdings anders als dieser freiwillig, einen riesigen Stein einen hohen Berg hinauf, jedoch nur, um sich anschließend wie unbändig am Zurückrollen des Steins ins Tal zu erfreuen.

Fazit

Sicher, mitunter ist Prozessarbeit die reinste Mühsal und man fragt sich zurecht, wie es dazu kommen konnte immer wieder durch dieses tiefe, triste Tal schreiten zu müssen. Jedoch etwas verändern, mitgestalten und verbessern zu können erfüllt mich jedes Mal mit derselben Begeisterung wie unseren indischen Freund Naranth, der ähnlich dem Camus’schen Sisyphos sein Augenmerk nicht darauf richtet immer und immer wieder dasselbe zu tun, sondern reine Freude darüber empfindet Dinge in Bewegung (im wahrsten Sinn des Wortes) gebracht zu haben.

Erfolgsmotor Fehlerkultur: Wie Innovation wieder möglich wird

Wir alle machen Fehler. Fehler sind die Quelle unserer Erfahrungen. Aus ihnen lernen wir. Sie fördern unsere Entwicklung und helfen uns Verhalten und Gewohnheiten zu hinterfragen und neue Lösungsstrategien zu entwickeln.

Versuch und Irrtum – schon seit Lucy[1] ein Renner

So ist es kaum verwunderlich, dass „Versuch und Irrtum“ wohl das älteste und mit Abstand erfolgreichste Entwicklungsprinzip in der Menschheitsgeschichte repräsentiert. Wie hätten wir sonst gelernt, selbst Feuer zu machen, Getreide zu pflanzen oder wären gar auf die Idee zu kommen daraus Mehl zu mahlen und Brot zu backen.

Jede Erfahrung, die wir machen, enthält einen Lerneffekt für die Zukunft, der uns zu besseren Entscheidungen, Handlungen und Ergebnissen führt.

Ein praktisches Beispiel für das „Versuch und Irrtum“-Prinzip durchläuft dabei jeder Mensch in frühen Jahren. Kinder erlernen nach genau demselben Muster das Gehen. Losgehen, hinfallen, aufstehen, wieder losgehen. Kein Kind überlegt sich vorher einen Plan, was wohl die beste Vorgehensweise sein könnte. Es wird einfach ausprobiert, bis es gelingt. Versuch und Irrtum in Reinform.[2]

Sicherlich ist die Methode nicht für jede Eventualität geeignet. Für eine Prüfung werden ihnen wohl in den wenigsten Fällen fünfzehn Fehlversuche zugestanden bis sie irgendwann einmal das richtige Ergebnis erzielen. Im Großen und Ganzen schmälert das die Einsatzgebiete der Methode aber nur geringfügig. In vielen Arbeits- und Lebensbereichen können wir nach dem Motto Versuch macht klug eine Menge lernen.

Ohne dieses elementare Entwicklungsprinzip würden wohl immer noch Laternenanzünder durch die Straßen unserer Städte laufen, um allabendlich Gaslampen zum Leuchten zu bringen. Thomas Alva Edison, einer der genialsten und produktivsten Erfinder unserer Zeit, hat seine Forschungsarbeit zur Entwicklung der Glühlampe lapidar mit den Worten zusammengefasst:

„Ich bin nicht 10.000 Mal gescheitert, sondern ich habe erfolgreich 10.000 Varianten entdeckt, die nicht funktionieren.“

Erst seit vergleichsweise kurzer Zeit in der Menschheitsgeschichte, haben wir begonnen dieses Entwicklungsprinzip gegen langwierige theoretische Überlegungen einzutauschen. In der Arbeit bringen wir endlose Zeit mit Meetings und Workshops zu, in denen vieles theoretisch bleibt. Teilweise über Monate werden Strategien und Konzepte erdacht, verfeinert, angepasst und erweitert. Bevor die erste wirkliche Handlung erfolgt, gehen unzählige Arbeitsstunden verloren. Ob es wirklich funktioniert, zeigt sich trotzdem erst hinterher.

Was bringt uns also dazu diese seit vielen Jahrtausenden erfolgreich erprobte Methode in unserem Büroalltag immer wieder zu vergessen?

Die Angst vor dem Fehler als Keimzelle institutionalisierten Perfektionismus

Schon als Kinder werden wir darauf trainiert, dass Fehler etwas Schlechtes sind. So ist sie tief in uns verwurzelt, die Angst vor dem Fehler. Wer kennt es nicht aus Schule und Studium: ein Fehler wird bestraft, ein Fehler führt zu schlechten Noten. Doch damit nicht genug. Im Arbeitsleben werden Fehler oftmals detektivisch aufgearbeitet, um den Verursacher zu identifizieren. Prima, Problem erkannt, Problem gebannt. Arbeitsgruppen werden eingerichtet, um ein zukünftiges Auftreten desselben Fehlers zu verhindern. Der Fokus auf Fehler bringt eine unangenehme Eigenschaft mit sich. Wir marschieren in die Richtung, auf die wir uns konzentrieren. Sprich, wer ständig mit der Angst lebt am Tisch nicht kleckern zu dürfen, bei dem steigt die Wahrscheinlichkeit, dass genau das passiert. Ähnliches lässt sich auch in Organisationen beobachten.

Die Null-Fehler Kultur hinterlässt noch immer ihre Spuren

Besonders mit dem Aufkommen der „Zero Fault Tolerance“-Bewegung der 80er und 90er Jahre wurden Fehler stark dämonisiert. Seither fließt in deutschen Unternehmen enorm viel Zeit und Geld in die Planung Prozesse und Produkte so perfekt wie möglich zu gestalten.

So brachte der deutsche Maschinenbau-Konzern Schaeffler noch vor kurzem sein Selbstverständnis mit folgenden Worten zum Ausdruck[3][4]:

„Das Ziel unserer Qualitätspolitik erschöpft sich nicht darin fehlerhafte Produkte zu entdecken und auszusortieren. Unser Qualitätsdenken sorgt vielmehr dafür, dass Fehler erst gar nicht entstehen. Null Fehler ist deshalb das erklärte Unternehmensziel.“

Schaeffler steht mit dieser Denkweise nicht allein da. Nach wie vor leiden deutsche Unternehmen unter den Nachwirkungen der Null-Fehler Bewegung. Fehler werden verteufelt und deren Verursacher stigmatisiert. Anders betrachtet. Wer immer wieder negatives Feedback für Fehler bekommt, der wird seltener mit neuen Ideen um die Ecke kommen. Im Gegenteil: Eine negativ besetzte Fehlerkultur führt häufig zu Stress, Leistungsdruck und fehlgeleitetem Perfektionismus.

Menschen sind darauf programmiert negativ auf Fehler zu reagieren

Fehler sind per se weder gut noch schlecht. Allerdings sind wir biologisch, evolutionär und kulturell darauf programmiert auf Fehler negativ zu reagieren.

Evolutionsbedingt tragen wir noch die Erfahrungen unserer felltragenden Vorfahren in uns. Diese mussten schmerzlich lernen, dass selbst kleinste Fehler fatale Auswirkungen haben können. Sich beispielsweise zu weit vom Stamm entfernen, versehentlich das Feuer ausgehen lassen oder durch hohes Steppengras laufen, konnte im Zeitalter von Mammut und Säbelzahntiger bereits eine tödliche Bedrohung darstellen.

Hinzu kommen prägende kulturelle Einflussfaktoren wie unsere Erziehung und die Gesellschaft, in der wir leben, die unseren Umgang mit Fehlern definieren.

Nicht zuletzt definiert die eigene Persönlichkeit, repräsentiert durch in unserem Gehirn stattfindende biochemische Vorgänge, wie unser Fehlerverhalten aussieht. Beschuldigen wir andere oder suchen wir die Schuld zuallererst bei uns selbst.

Negativ besetzte Fehlerkultur ist innovationsfeindlich und agilitätshemmend

In Organisationen mit negativ besetzter Fehlerkultur mündet der Umgang mit Fehlern fast automatisch in ein personenzentriertes[5] Vorgehen. Mittels disziplinarischer Maßnahmen wird versucht das Auftreten des Fehlers zukünftig zu verhindern. Das vorherrschende Paradigma folgt der Suche nach einem individuellen Sündenbock. Diese Haltung verhindert im Wesentlichen eine objektive Analyse des Fehlers. Zudem werden systemische Fehler, d.h. inwieweit das vorherrschende System die Fehlerentstehung begünstigt, nicht erkannt und können nicht eliminiert werden. Das Resultat: weiterer Schaden ist zu befürchten.

Doch damit nicht genug. In einem fehlerfeindlichen Umfeld leidet auch die Innovationskraft des Unternehmens. Organisation und Mitarbeiter werden alles Erdenkliche tun, um das Auftreten von Fehlern zu vermeiden. Bedauerlich, denn unsere Kulturgeschichte ist voll von folgenschweren Erfindungen, die auf einen Fehler zurückgehen. Glühbirne, Dynamit, Porzellan, Mikrowelle, ja selbst Viagra hat uns ein Fehler geschenkt.

Der weltbekannte Erfinder James Dyson hat vor einiger Zeit während eines Deutschlandaufenthaltes seine Haltung zu Fehlern auf den Punkt gebracht[6]:

„Ich glaube an Fehler. In der Schule hat man uns gesagt: Ihr müsst immer die richtige Antwort geben, und zwar beim ersten Mal. Das ist absolut der falsche Weg. So lernen sie nichts außer der richtigen Antwort. Ich würde Menschen danach bewerten, wie viele Fehler sie gemacht haben. Je mehr Fehler, desto besser. Egal ob sie einen Film drehen, ein Buch schreiben oder eine Technologie entwickeln: Sie gehen doch immer los und wissen nicht genau, wo sie herkommen. Nur durch Fehler machen wir Entdeckungen.“

Besser werden durch Fehler machen

Den wohl größten Gefallen, den sich ein Unternehmen erweisen kann, ist das Eingeständnis der simplen Tatsache, dass Menschen eben Fehler machen. Nun muss sich keine Organisation dieser Welt mit einem fatalistischen Fehlerumgang anfreunden. Vielmehr sollte sie sich fragen, inwieweit Prozesse und Arbeitsdesign so gestaltet werden können, dass sie Fehler entweder grundsätzlich vermeiden, sie - bevor sie größeren Schaden anrichten - rechtzeitig erkennen oder ihre Auswirkungen minimieren. Der Vorteil dieser Denkweise liegt auf der Hand. Fehler werden als Teil des Systems betrachtet, der Umgang mit ihnen zugelassen und sogar als wünschenswert erachtet. Ein besonders positiver Nebeneffekt: Mitarbeiter haben keine Angst mehr einen Fehler zu machen. Innovation wird wieder möglich.

Fazit

Kein Wunder also, dass sich Unternehmen mit negativ Fehlerkultur zusehends schwer tun Innovationen auf den Markt zu bringen oder agile Zusammenarbeit im operativen Tagesgeschäft einzuführen.

Erst eine positive besetzte Fehlerkultur schafft die Voraussetzungen für Agilität und Innovationsfähigkeit. Das Agieren ohne Angst, ein Miteinander auf Augenhöhe und das gemeinsame Streben das System zu verbessern bilden die Eckpfeiler agilen Denkens. Nicht das Streben nach Perfektion darf im Fokus von Unternehmen stehen, sondern Fortschritt und Weiterentwicklung. Die Fähigkeit sich ständig zu hinterfragen und rasch auf Veränderungen zu reagieren.

[1] https://www.zeit.de/wissen/2016-08/vormensch-lucy-baumsturz-tod-studie?utm_referrer=https%3A%2F%2Fwww.google.com%2F

[2] https://karrierebibel.de/versuch-und-irrtum-prinzip/

[3] https://www.schaeffler.com/remotemedien/media/_shared_media/09_investor_relations/dokumente/publikationen/2012/Schaeffler_GB_2012.pdf

[4] https://www.schaeffler-nachhaltigkeitsbericht.de/2017/handlungsfelder/kunden-und-produkte/produktverantwortung.html

[5] https://key2agile.de/null-fehler-kultur-no-agile-teil-1/

[6] https://www.ingenieur.de/technik/fachbereiche/gebaeudetechnik/nur-fehler-entdeckungen/

Führt Produktqualität ins Abseits?

In meinen Trainingskursen kommt früher oder später immer wieder die Frage nach dem Unterschied zwischen Produkt- und Prozessqualität auf. Zu dieser Frage unterhalte ich eine sehr pointierte Sichtweise. Steht in einem Unternehmen die Produktqualität im Vordergrund, d.h. wird das Produkt auf seinem Weg zur Fertigstellung immer wieder qualitätsgesichert, geprüft, vermessen, gewogen oder getestet bedeutet das in der Regel nur eines. Das Unternehmen hat kein Zutrauen in seine eigenen Abläufe. Noch etwas nachdrücklicher formuliert ist eine Fokussierung auf die Produktqualität meist ein Hinweis auf vorherrschende Prozessprobleme. Dazu gehören typische Symptome wie fehlende Standards, ein geringer Automatisierungsgrad, mangelnde Kooperation in der Ablauforganisation, Medienbrüche und individuelle, vom Bearbeiter abhängige, Prozessausführung. Das führt meist zu einem Prozessverhalten, dass nur eingeschränkt vorhersagbar ist und überträgt sich dann naturgemäß auch auf das Produkt. Einmal führt der Prozess zu einem gewünschten Ergebnis, ein andermal zu einem unerwarteten im schlimmsten Fall fehlerbehafteten Resultat. Kein Wunder also, dass sich die Organisation an das Produkt „hängt“ und stets dessen Qualität im Auge behalten möchte.

Reine Produktsicht als Wettbewerbsnachteil?

Klar, kein Konsument hat Interesse in den Genuss fehlerbehafteter Produkte oder Dienstleistungen zu kommen. Sicher ist aber auch, dass Konsumenten wenig Interesse haben für exzessive Qualitätssicherung unnötig Geld auszugeben. Aber genau das passiert in Organisationen die Produkt- vor Prozessqualität stellen. Lassen sie es mich so ausdrücken. Die Absicherung der Produktqualität steht für eine Kompensationsleistung. Kompensiert werden mangelhafte, teilweise dysfunktionale Prozesse und eine unterentwickelte Prozessorientierung.

Warum ist die Produktsicht in vielen Organisationen überhaupt so stark ausgeprägt? Typischerweise kann dieses Organisationsverhalten auf zwei relevante Einflussfaktoren zurückgeführt werden.

Zum einen ist da die typische nach wie vor tayloristisch, also mehr oder weniger arbeitsteilig, ausgerichtete Aufbauorganisation. Jeder Bereich in so einer Organisation kann nur einen geringen Teil der Wertschöpfung - manchmal sind es sogar nur einzelne Arbeitsschritte - eines Produktes verantworten. Diese Arbeitsteilung führt dazu, dass Produkte mindestens zweimal, bei Entgegennahme und Weitergabe, auf Mängel geprüft werden. Handelt es sich um ein komplexeres Produkt an dem zahlreiche unterschiedliche Organisationseinheiten beteiligt sind, kann man sich vorstellen, dass die Aufwände für die Qualitätssicherung einen unverhältnismäßig hohen Anteil an den Produktkosten stellen.

Anders formuliert, ist die vorherrschende Perspektive auf die im Unternehmen ausgeführten Aktivitäten, die Sichtweise einer bereichsorientierten Aufbauorganisation, wird auch jede Organisationseinheit für die Qualität seiner Arbeitsschritte verantwortlich gemacht. Konsequenterweise steuert jeder Bereich eines solchen Unternehmens, dass was er kontrollieren kann. Das ist letztlich der Qualitätsanteil der Wertschöpfungsschritte, für die jede Einheit verantwortlich ist.

Damit kommen wir zum zweiten dominierenden Einflussfaktor. Er findet sich in der, in einer Organisation, vorherrschenden Fehlerkultur. Werden Fehler verteufelt und als Versagen stigmatisiert, wird die Organisation alles tun, um eben diese Fehler zu vermeiden. Forschungs- und Entwicklungsprozesse werden unerträglich lange Laufzeiten vorweisen. Ebenso wird es Konzeptions-, Design- und Spezifikationsprozessen ergehen. Die Angst vor einem Fehler wird eine fehlerintolerante Organisation lähmen und dazu führen, dass erst einmal alles was zu einem Fehler führen könnte ausgeschlossen wird. Diese Kultur führt schlussendlich ebenfalls zu einer ungesunden Intensivierung der Qualitätssicherungsbemühungen.

Beide Einflussfaktoren führen nicht nur dazu, dass der Anteil an der Wertschöpfung sinkt und durch vermeidbare Blind- und Stützleistung verwässert wird sondern auch dass die Produktkosten in die Höhe getrieben werden. Zusätzlich werden in so einem Prozess die Durchlaufzeiten unnötig verlängert und der Durchsatz beeinträchtigt. Alles in allem führt uns der rein produktzentrierte Qualitätsansatz in einem wettbewerbsorientierten, vergleichbaren Marktumfeld ins Abseits.

Prozessqualität ist die Voraussetzung für verbesserte Kollaboration und zunehmende Agilität

Ganz anders stellt sich die Situation in Unternehmen dar, die Prozessqualität ins Zentrum ihrer Aufmerksamkeit rücken. Was aber bedeutet Prozessqualität eigentlich? Unter Prozessqualität ist das Verhalten eines Prozesses unter gewissen, teilweise veränderlichen, Rahmenbedingungen zu verstehen. Die zentrale Frage die tagein, tagaus immer wieder aufs Neue beantwortet werden muss: verhält sich der Prozess so, dass sein Verhalten vorhersagbar ist und immer wieder zum gleichen Ergebnis führt? Um diese Frage beantworten zu können, braucht es ein Kontrollmittel, das uns darüber Auskunft gibt, wie oft der Prozess ein identisches Verhalten gezeigt hat. Dieses Mittel finden wir in der Standardabweichung. Die Standardabweichung[1] ist eine statistische Kontrollgröße (Kennzahl) die uns darüber Auskunft gibt, wie oft ein Prozess von einem gewünschten Zielwert abweicht und wie groß diese Abweichung im Mittel ist. Sie wird nie alleine die Qualität eines Prozesses beschreiben können, sorgt aber als Kontrollgröße in Kombination mit einer weiteren Kernkennzahl für entsprechende Aussagekraft.

Dazu ein Beispiel. Ein Möbelhersteller sah sich aufgrund unzufriedener Kunderückmeldungen zu einer Analyse seines Bestellprozesses veranlasst. Bereits die Einführung aussagekräftiger Kennzahlen in Form der durchschnittlichen Lieferzeit und der dazu korrespondierenden Standardabweichung deckte sehr schnell die Unzuverlässigkeit des Bestellprozesses auf. Kunden erhielten bei der Bestellung Lieferzusagen, die in der Hälfte der Fälle nicht eingehalten wurde. Teilweise kam es zu sehr starken Abweichungen zum vereinbarten Lieferzeitpunkt. Eine weiterführende Analyse zeigte, dass die Organisation mit allen Mitteln versuchte die Lieferzeit zu verkürzen. Dies brachte in zahlreichen Fällen auch Qualitätsprobleme mit sich. Schlampige Arbeiten oder das Ausliefern unvollständiger Möbelstücke verschärften das Problem zusätzlich. Das Unternehmen konzentrierte sich in der Folgezeit auf die Verbesserung seiner Prozessqualität und arbeitete die Ursachen auf, die zu einem unzuverlässigen Bestellprozess geführt hatten. Heute ist das Unternehmen im deutschen Sprachraum Nischen-Marktführer.

Neue Spielräume durch echte Prozessorientierung im Qualitätswesen?

Aus diesem Praxisbeispiel lassen sich verschiedene wertvolle Einsichten gewinnen. Zum einen gilt, je geringer die Standardabweichung, d.h. die Streuung um den Ergebnismittelwert (bspw. Durchlaufzeit, Kundenzufriedenheit, Durchsatz, etc.) umso qualitativ hochwertiger ist der Prozess und die damit erzielbaren Ergebnisse. Weniger Varianz im Prozessergebnis entlastet zudem die Organisation bei Nacharbeiten, Retouren und Rückrufen. Zum anderen fallen in Prozessen, die nach ihrer Ergebnisvarianz optimiert und gesteuert werden deutlich weniger Qualitätssicherungsaufwände an, da ja Werkstücke und Dienstleistungen nicht ständig überprüft werden müssen. Der Entfall dieser Aufwände wirkt zudem noch konsumentenfreundlich. Es erlaubt dem Unternehmen Produkte schneller und günstiger zu produzieren.

Noch ein weiterer Pluspunkt lässt sich für die Organisation selbst ableiten. Steht die Prozessqualität (und damit letztlich auch die ständige Wiederholbarkeit qualitativ hochwertige Produkte zu erzielen) im Vordergrund sind alle Bereiche diesem Ziel verpflichtet. Divergierende Bereichsinteressen treten in den Hintergrund, vielmehr etabliert sich eine gemeinsame Sicht auf das Prozessergebnis. Der Wille zur Kooperation wird gestärkt und Prozess und Prozessorientierung stehen mehr und mehr im Vordergrund. Diese kollaborative Prozesssicht öffnet überdies die Tür für andere Formen der Zusammenarbeit da die Starre traditioneller in Bereichssichten geteilter Prozesse aufgelöst wird. Es wird leichter Veränderungen (beispielsweise Änderungen am Prozess, neue Funktionalitäten am Produkt) in kleinen Pilotphasen auszuprobieren und agilere Formen des Prozessmanagements einzuführen.

[1] Die Standardabweichung wurde durch Six Sigma ein Teil prozessorientierter Kennzahlen. Im Kern beschreibt sie die Abweichung von einem Mittelwert.

Die Heimkehr der Prozesse

Schmelzende Kostenvorteile und die Verfügbarkeit neuer Technologien beschleunigt ein Umdenken in Firmenzentralen. Immer mehr Unternehmen verlagern ihre Prozesse zurück ins Stammland. Neuartige Prozesstechnologien wie Robotic Process Automation und Maschinelles Lernen schneiden tief in den Business Process Outsourcing Markt und unterstützen den aufkeimenden Insourcing-Trend.

Im Verlauf der letzten 20 Jahre haben Unternehmen branchenunabhängig immer wieder einen Teil ihrer Prozesse an externe Dienstleister, meist in Billiglohnländer wie Indien, China und Vietnam, ausgelagert.

Gründe für das Outsourcing waren und sind für Firmen vor allem immer wieder die Erzielung von Kosten-, Flexibilitäts- und Qualitätsvorteilen. Allerdings wurden seit jeher diese Vorteile u. a. durch deutlich höhere Kommunikations- und Steuerungsaufwände, Kontrollverluste, gestiegene Abhängigkeiten, ein verschlechtertes Betriebsklima und ungewollte vertrauliche Einblicke ins Kerngeschäft mitunter teuer erkauft.

Daher verwundert es nicht, dass Firmen munter darüber nachdenken, vor Jahr und Tag ausgelagerte Prozesse wieder in heimischere Regionen zurückzuführen. Neben schrumpfenden Kostenvorteilen[1] in asiatischen und osteuropäischen Outsourcing-Zentren fungiert die zunehmende Automatisierung als Treiber der aufkeimenden Insourcing-Bewegung.

RPA unterläuft Kostenvorteile durch Business-Process-Outsourcing

Gerade im Bereich der Prozessautomatisierung egalisiert Robotic Process Automation immer häufiger die Gründe für komplizierte Outsourcing-Verfahren. Streng genommen ist RPA ja auch eine Form von Outsourcing, aber eben an einen Roboter (oder eine Roboterfarm) anstatt eines externen Dienstleisters.

So werden 2021 bereits mehr als vier Millionen Roboter[2] in der Prozessautomatisierung ihren Dienst versehen.

Eines ist ganz klar. Der Markt für Software-botgestützte Automatisierung von Prozessen boomt. Waren es im Jahr 2016 noch ca. 250 Millionen US-Dollar, verzwölffacht sich der Markt innerhalb von fünf Jahren auf 2,9 Milliarden[3] US-Dollar in 2021. Zwei von drei Unternehmen[4] werden 2020 bereits RPA-Serviceleistungen in Anspruch nehmen, Tendenz steigend. Noch sind es überwiegend Großunternehmen mit »reifer IT«, d. h. zahlreiche Prozesse laufen dort bereits weitgehend IT-gestützt (wenn auch nicht frei von Medienbrüchen und manuellen Routineaufgaben) ab.

BPO-Marktentwicklung zeigte bereits vor Corona einen rückläufigen Trend

Betrachtet man einmal nicht das über Jahre an Billiglohnländer übertragene akkumuliert anwachsende BPO-Volumen, sondern die jährlichen vergebenen BPO-Vertragsvolumina zeigt sich ein weitaus aufschlussreicheres Bild (siehe Abb. 01). Der BPO-Markt ist seit seinem Höchstwert von 36,5 Mrd. US-Dollar im Jahre 2012 rückläufig. So hat sich das seit Erreichen des Höchstwertes vergebene Vertragsvolumen in den letzten Jahren bereits um ein gutes Drittel auf etwa 24 Mrd. US-Dollar reduziert. Einen wesentlichen Anteil daran hat die zunehmende Prozessautomatisierung.

Abb. 01: Jährliche Entwicklung der vergebenen BPO-Vertragsvolumina in Mrd. US-Dollar[5]

RPA, als ein stetig an Bedeutung gewinnender Vertreter dieser Gattung, wurde bereits genannt. Nicht unterschlagen sollte man in diesem Zusammenhang auch die wachsende Bereitschaft der Unternehmen Prozesse intelligenter auszugestalten. In zahlreichen Organisationen sind Prozesse bereits zu rudimentären Verhaltensvorhersagen (u.a. Predictive Maintenance, Fehler-Frühwarnungen) fähig. Auch diese Entwicklung übt einen günstigen Einfluss auf die Prozesskosten aus.

Entscheidend ist in all diesen Fällen, dass bereits schrumpfende Kostenvorteile in den Billiglohnländern weiter an Attraktivität verlieren.

Fazit

Bringt man in diese Gleichung noch die durch die Corona-Pandemie arg gebeutelten und zum Zerreißen gespannten Just-in-Time betriebenen Wertschöpfungsketten ein, wird ein Einstieg, vor allem für Unternehmen die noch nicht oder kaum BPO- und Shared Service Angebote nutzen, zusehends unattraktiver und riskanter. Zu diesem Trend gesellt sich auch eine zunehmende regionale Lokalisierung von Unternehmensstandorten durch rechtlich-, ökologisch- und sozial unterschiedliche Entwicklungen.

[1] Buchter, Heike: »Schluss mit der Globalisierung«, in: Zeit Online, 18.10.2017, Zugriff: 10.11.2019.

[2] The Forrester Wave™: Robotic Process Automation, Q1 2017, https://www.forrester.com/report/The+RPA+Market+Will+Reach+29+Billion+By+2021/-/E-RES137229 (Zugriff: 27.04.2020).

[3] The Forrester Wave™: Robotic Process Automation, Q1 2017, https://www.forrester.com/report/The+RPA+Market+Will+Reach+29+Billion+By+2021/-/E-RES137229 (Zugriff: 27.04.2020).

[4] Deloitte Consulting, https://www2.deloitte.com/bg/en/pages/technology/articles/deloitte-global-rpa-survey-2018.html (Zugriff: 27.04.2020).

[5] www.statista.de (Zugriff 12.11.2020), https://www.statista.com/statistics/190150/industrywide-contract-value-business-process-outsourcing/

Was zusammengehört soll man nicht trennen

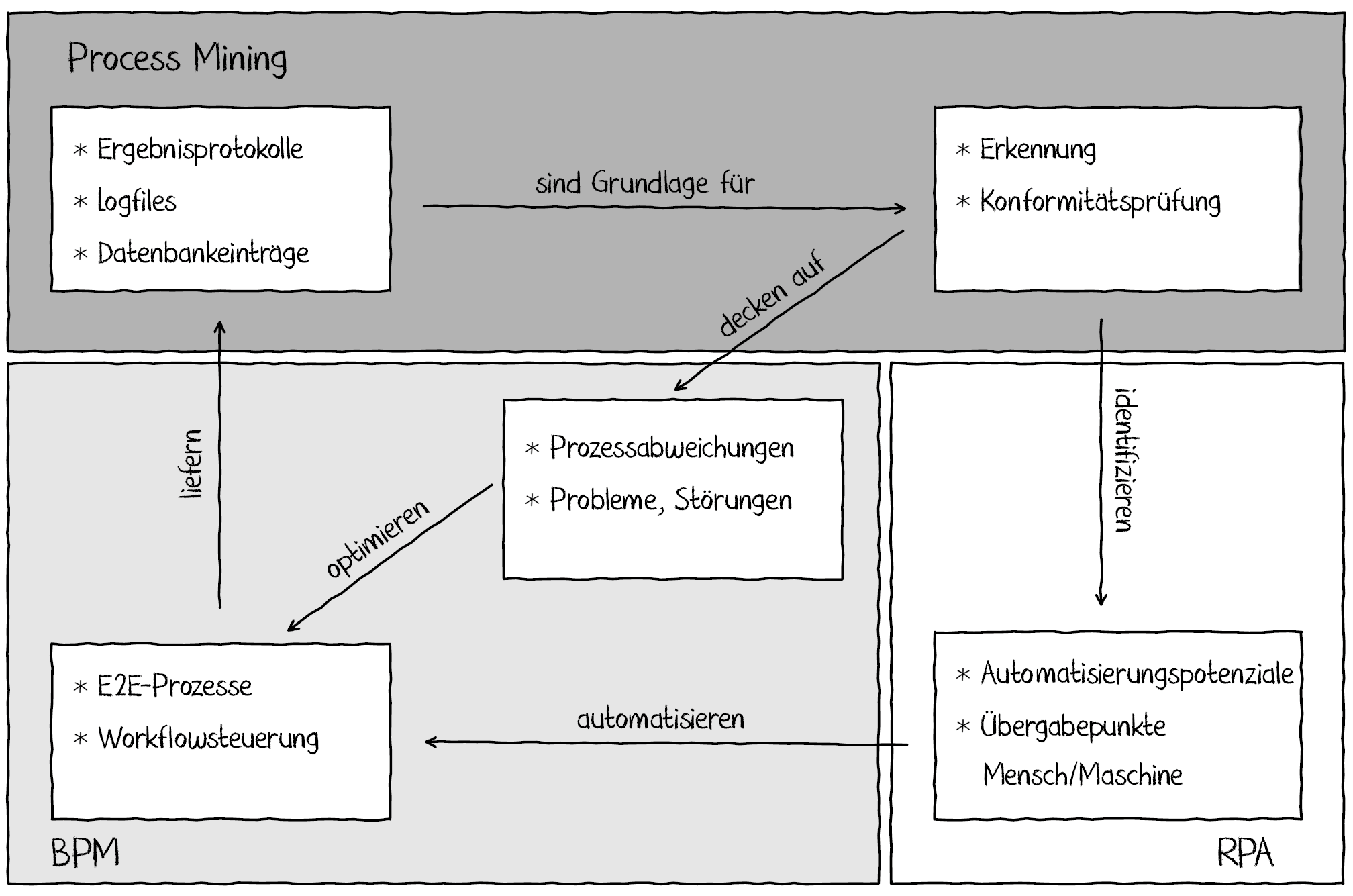

Die digitale Transformation, nicht erst durch Corona eines der heißesten Aktionsfelder in Unternehmen, macht auch nicht vor dem Prozessmanagement halt. Business Process Management (BPM), Process Mining und Robotic Process Automation (RPA) bilden dabei den heiß umkämpften Schauplatz weitreichender Digitalisierungsbemühungen. Einzeln für sich kann jede dieser Disziplinen nicht ihr volles Potential abrufen. Erst durch den abgestimmten, gemeinsamen Einsatz dieser Technologien gelingt es eigene Defizite zu umgehen und umfassende Verbesserungen an den Prozessen vorzunehmen.

Alleine noch unvollständig

„Process Mining“ ist eine junge Disziplin aus dem Data Mining Kosmos. Sie beschäftigt sich vorwiegend mit der Analyse und Auswertung von Ereignisdaten, die in IT-Systemen bei der Verarbeitung von Daten standardmäßig anfallen. Die Auswertung dieser Daten erlaubt einen Abgleich mit bestehenden Prozessmodellen und liefert so ein Bild über den tatsächlichen Prozessverlauf und an welchen Stellen dieser von den im Prozess Design getroffenen Vorgaben abweicht. Während die Technologie für ein notwendiges und vertiefendes Verständnis des Prozessverlaufes sorgt, kann sie jedoch keine Prozesskorrekturen vornehmen oder Prozessschritte automatisieren.

Bei der Automatisierung von Prozessen kann wiederum „Robotic Process Automation“ Abhilfe schaffen. Im Kern handelt es sich um die Automatisierung von Vorgängen, die ein hohes Maß an wiederkehrenden manuellen Arbeitsschritten auszeichnen. Roboter, sogenannte „Bots“, übernehmen eins zu eins die Tätigkeiten eines menschlichen Bearbeiters. Auf diese Weise können Medienbrüche oder traditionell manuell abgewickelte Vorgänge automatisiert werden. Dabei handelt es sich aber nur um eine scheinbare Prozessoptimierung. Der Prozess an sich erfährt keine Veränderung, es findet lediglich eine Übertragung von Arbeit statt, die zuvor ein Mensch geleistet hat. Oftmals lassen sich die einzelnen, im Prozess verteilten, Automatisierungsschritte auch nicht nachvollziehen. Der tatsächliche Prozessverlauf bleibt also nach wie vor im Dunkeln.

Hilfe bei der Korrektur von Prozess-Soll/Ist-Abweichungen gewährt das „Business Process Management“. Es unterstützt beim Design bzw. der Anpassung von Geschäftsprozessen und deren Einhaltung und Überwachung durch die Implementierung von Workflows. Allerdings sind diese Lösungen nicht in der Lage die tatsächlichen Prozesse und deren Leistungsfähigkeit zu erfassen. Eine Einsicht, inwieweit der Ist-Zustand vom Soll-Zustand abweicht, gewähren sie indes nicht.

Vereint stärker

Die angesprochenen Defizite der einzelnen Technologien führen zu einer zunehmenden Integration von RPA-, BPM- und Process-Mining- Lösungen (siehe Abbildung 1).

Abb. 1: Zusammenspiel von BPM, RPA und Process Mining[1]

Beispielsweise arbeitet der RPA-Hersteller UiPath mit dem Process-Mining-Anbieter Celonis[2] bereits an Lösungen, um Prozesse mit dem höchsten Automatisierungspotenzial zu identifizieren und zu visualisieren, mit dem Ziel, entsprechende RPA-Bots zu entwickeln, zu testen und auf den identifizierten Prozess anzuwenden. Andere RPA-Hersteller berichten von ähnlichen Anwendungsfällen. Die technische Exhumierung von Prozessen – anhand von Spuren im Datendschungel – hilft, die tatsächlichen Prozessverläufe zu rekonstruieren und die für eine Automatisierung in Frage kommenden Teilprozesse bzw. Tätigkeitsfolgen zu enthüllen. Konformitätsüberprüfungen, d.h. der Abgleich zwischen bestehendem Prozessmodell und tatsächlichem Prozessverlauf, wiederum können dazu verwandt werden, Prozessabweichungen festzustellen, Probleme vorherzusagen und Übergabepunkte von RPA-Bots zu Menschen (Medienbrüche, Integrationsbruchstellen) aufzuzeigen.

Auch von gänzlich anderer Seite wird ebenfalls eine stärkere Integration mit RPA-Lösungen angestrebt. Der BPM-Hersteller Software AG bietet zu seinem Flagship-Produkt ARIS seit Kurzem nun auch eine RPA-Lösung[3] an.

Fazit

In den nächsten Jahren bleibt die technologische Entwicklung also weiterhin spannend: Eine deutlichere Integration dieser Prozesstechnologien ist zu erwarten. Durch den gemeinsamen Einsatz dieser drei Technologien entsteht ein modernes digitales Prozessmanagement, welches sich individueller Stärken besinnt und im Ensemble zunehmend bestehende Schwächen abstellt und bessere Ergebnisse liefert.

[1] Hierzer, Rupert (2020): Prozessoptimierung 4.0 – Den digitalen Wandel als Chance nutzen (2. Auflage), Freiburg, S. 235

[2] W.M.P. van der Alst et al.: Robotic Process Automation, Business Information Systems Engineering 60(4): 269–272 (2018)

[3] www.softwareag.com, https://resources.softwareag.com/products-process/2019-4-fs-aris-rpa-en-robotic-process-automation-fact-sheet (Zugriff: 08.01.2020)

Skitouren - ein Mittel gegen den Corona-Frust

Keine Frage. Corona hat den Wintertourismus und die Skiindustrie schwer getroffen. Vorzeitige Schließungen der Wintersportgebiete und eine erschwerte Zukunftsplanung haben für einen signifikanten Orderrückgang bei den Ski-Herstellern gesorgt:

„Im Vergleich zum Vorjahr haben wir in diesem Jahr einen circa 20 bis 25 Prozent niedrigeren Orderstand“,

berichtet Wolfgang Mayrhofer[1], Sprecher der österreichischen Skiindustrie.

Skitouren im Trend

Allerdings ist dieser Trend nicht bei allen Produkten gleich ausgeprägt. Gerade im Tourenski-Segment, das bereits in den Vorjahren jährliche Wachstumsraten von 20% und mehr aufwies, bahnt sich eine gegenläufige Entwicklung an. Es steht zu erwarten, dass die mittlerweile rund 600.000 Skitourengeher in Deutschland (500.000 sind es in Österreich) weiteren Zuwachs bekommen werden. Der Grund liegt auf der Hand. Das reduzierte Angebot bei Fernreisen und die hohe Planungsunsicherheit lässt viele Touristen umdenken. Hinzu kommt, dass viele Skigebiete noch nicht wissen mit welchen Auflagen sie in die Wintersaison starten. Kleinere Skigebiete kommen da schon ins Grübeln, ob unter diesen Umständen ein „normaler“ Betrieb wirtschaftlich überhaupt möglich ist.

Menschen streben wieder nach Beständigkeit und Selbstbestimmtheit

Dies führt zu einem Umdenken. Der Sommer hat bereits gezeigt, dass der Urlaub in den Bergen boomt und dieser Trend auch im Winter anhalten könnte. Statt Unsicherheit und regional unterschiedlicher Corona-Auflagen streben viele Menschen gerade nach einem Stückchen Beständigkeit und Selbstbestimmtheit. Der Zug hinaus in die Natur, auf eigene Faust unterwegs zu sein war bereits im Frühjahr und Sommer zu beobachten. Der Sportmarkt für Fahrräder und Laufartikel ging praktisch durch die Decke.

So ist auch dieses Jahr mit vielen Skitouren-Neueinsteigern zu rechnen. Zusehends werden Skitouren auch für Familien interessant wie die Absatzzahlen bei Kinderskiern belegen. Gerade auch kleinen Skigebieten bietet diese Entwicklung Chancen. In Gebieten, wo sich der Betrieb von Liftanlagen aufgrund begrenzter Pistenkilometer und Höhenlage schon länger nicht mehr rechnet könnte hier ein Gegenentwurf sanfteren Bergtourismus entstehen. So herrscht beispielswiese am Grünten im Allgäu ein regelrechter Ansturm von Skitourengehern seit dort die Lifte außer Betrieb genommen wurden. Andere Skigebiete bieten auf ihren Hütten nächtliche Tourenabende, um Toureneinsteiger abends zum ungefährlichen Aufstieg entlang der Piste zu locken.

Es lockt ein neues Naturverständnis

In dieser Entwicklung liegt eine Chance ein Stück Nähe zur Natur zurückzugewinnen. Abseits von dieselbetriebenen Aufstiegshilfen und lärmendem Massentourismus gelingt es einigen von uns vielleicht eine neue Balance mit unserer Umwelt wiederzufinden. Gerade da eröffnet die Pandemie, trotz allem Schreck und aller Widrigkeiten, auch eine Möglichkeit Alltagsängste und Stress, angesichts einer mit anderen Augen wahrgenommenen Natur, abzubauen und zu heilen.

[1] https://www.fr.de/wirtschaft/wintersport-mit-ski-und-schneeschuh-gegen-den-corona-frust-90024934.html